만약 지금 우리가 처음부터 서비스를 만든다면,

과연 코드를 먼저 짜야 할까요?

불과 몇 년 전까지만 해도 이 질문은 말이 되지 않았습니다.

서비스 개발은 곧 코딩이었고, 코딩을 잘하는 사람이 곧 실력자였습니다.

그런데 최근 스탠퍼드 대학교에서

이 전제를 다시 묻는 수업(CS146S)이 등장했습니다.

생성형 AI를 활용해 ‘코드를 짜는 법’보다 ‘어떻게 만들지’를 먼저 가르치는 강의입니다.

일부 기사에서는 이를 두고 “스탠퍼드가 더 이상 코딩을 가르치지 않는다”는 식의 자극적인 해석이 나오기도 했지만,

실제 메시지는 훨씬 현실적이고 중요합니다.

핵심은 코딩의 폐지가 아니라

서비스 개발에서 ‘코딩의 위치가 바뀌고 있다’는 선언입니다.

스탠퍼드의 새로운 강의는 무엇이 다른가

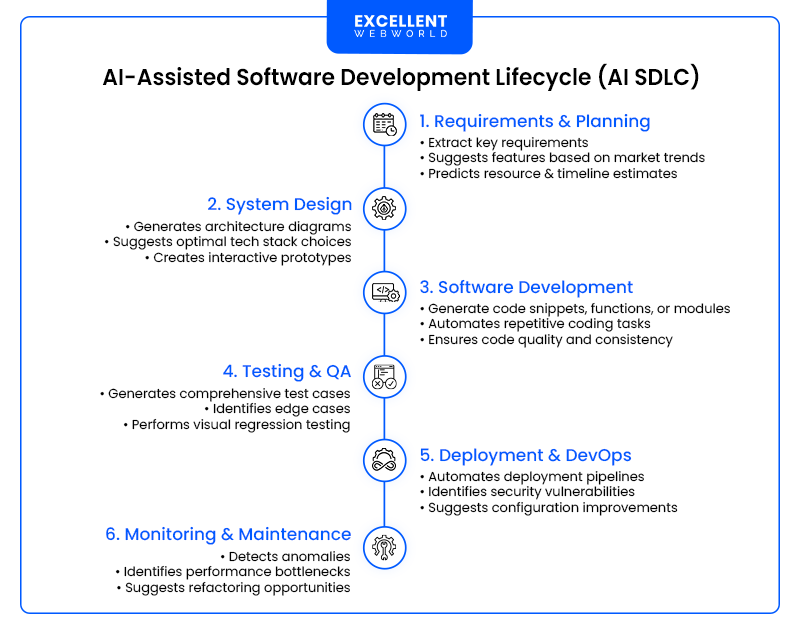

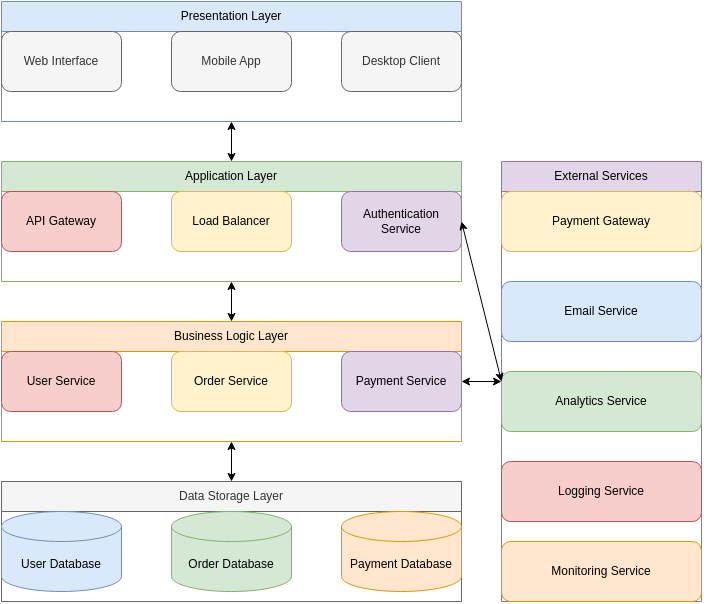

기존의 개발 교육은 보통 다음 흐름이었습니다.

요구사항 → 설계 → 직접 코딩 → 테스트 → 배포

그러나 스탠퍼드의 새로운 강의에서는 흐름이 이렇게 바뀝니다.

문제 정의 → AI에게 지시(Prompt) → 생성된 코드/로직 검토 → 수정·통합 → 서비스화

즉,

- 학생이 모든 코드를 직접 작성하지 않습니다

- 대신 AI를 개발 파트너처럼 활용하는 방법을 배웁니다

- 인간은 무엇을 만들지, 결과가 맞는지에 집중합니다

이는 이미 많은 현업 조직에서 조용히 진행 중인 변화이기도 합니다.

앞으로의 서비스 개발 방향성: “작성”에서 “설계”로

생성형 AI의 등장으로, 서비스 개발의 병목은 점점 개발 실력이 아니라 다음의 영역으로 바뀌고 있습니다.

1. 무엇을 만들 것인가 (Problem Definition)

- 문제를 잘못 정의하면 AI는 잘못된 결과를 만듭니다.

2. 어떤 입력을 줄 것인가 (Prompt & Context)

- 같은 AI라도 지시 방식에 따라 결과 품질은 크게 달라집니다.

3. 결과를 믿어도 되는가 (Validation & Judgment)

- AI가 만든 결과는 그럴듯해 보이지만, 항상 옳지는 않습니다.

결국 서비스의 품질은

AI의 성능이 아니라, 인간의 판단력에 의해 결정됩니다.

이 변화 속에서 우리의 역할은 무엇인가

이제 서비스 개발에서 인간의 역할은 다음으로 재정의됩니다.

- 코드를 치는 사람 → ❌

- 문제를 정의하고, AI의 출력을 검증하는 사람 → ✅

특히 데이터사이언티스트, 기획자, 운영 인력에게는 다음 역량이 중요해집니다.

- “이 결과가 실제 상황에서도 말이 되는가?”

- “데이터 편향이나 누락은 없는가?”

- “사용자에게 어떤 오해를 줄 수 있는가?”

이런 질문을 고려할 수 없다면 AI를 도입할수록 리스크가 커집니다.

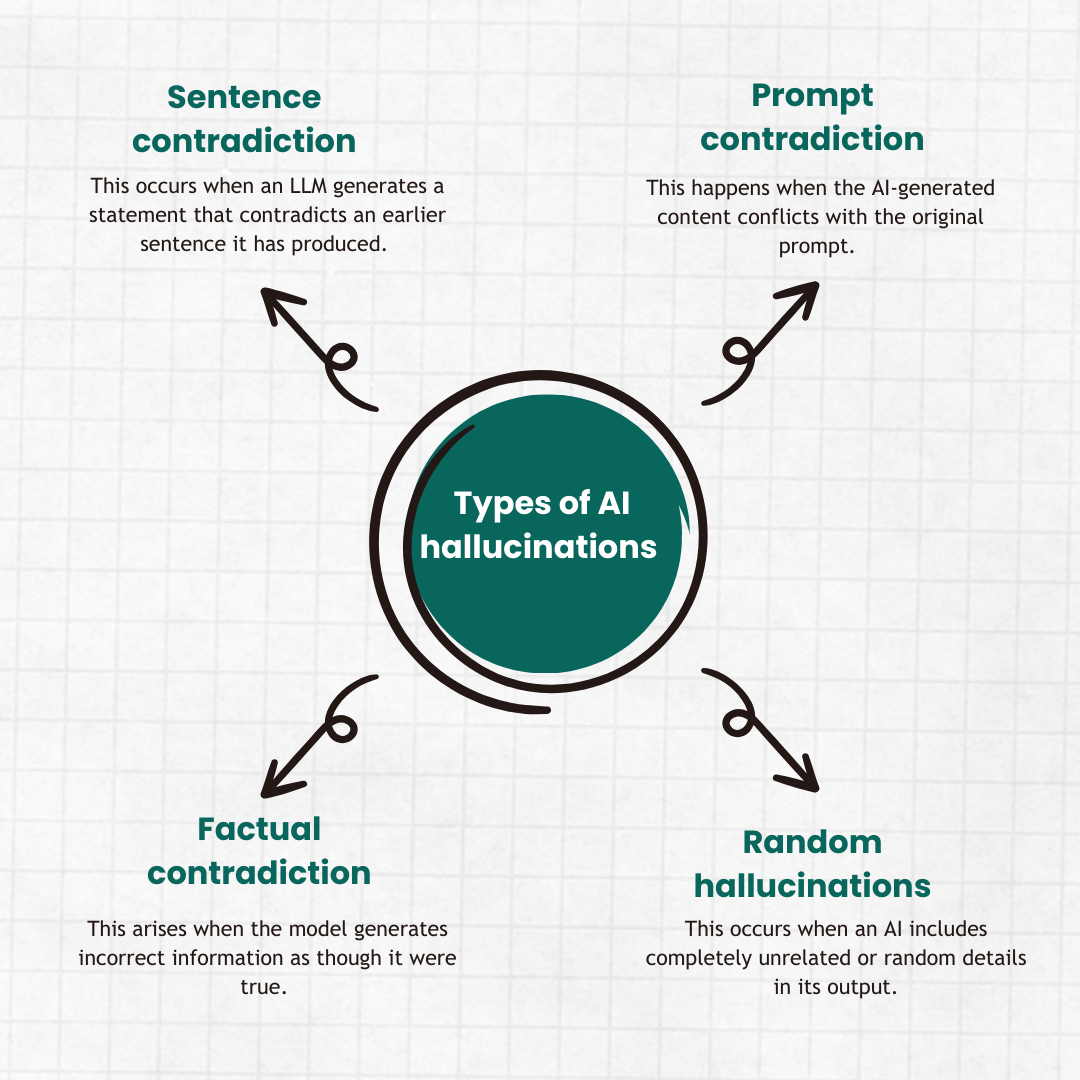

반드시 주의해야 할 점: AI는 책임을 지지 않는다

생성형 AI 기반 개발에서 가장 흔한 착각은 이것입니다.

“AI가 만들었으니 어느 정도 맞겠지”

하지만 AI는

- 책임을 지지 않고

- 맥락을 완전히 이해하지 못하며

- 틀려도 확신에 차서 말합니다 (Hallucination)

따라서 반드시 지켜야 할 원칙은 단순합니다.

AI는 도구이고, 최종 책임은 항상 사람에게 있다

마무리: 코딩은 사라지지 않는다, 다만 중심이 아니다

스탠퍼드 대학교의 선택은 미래 선언이 아니라 현실 반영입니다.

이미 우리는 다음 시대에 들어와 있습니다.

- 코딩은 여전히 필요합니다

- 그러나 경쟁력의 핵심은 문제 정의, 판단, 책임입니다

AI를 잘 쓰는 조직과 그렇지 못한 조직의 차이는

기술 수준이 아니라 사고 방식에서 비롯된다는 점이 어느때보다 중요한 지금입니다.

DS 박정현